这篇题为《神经成像的可解释人工智能方法:常用工具的系统性失效、特定领域验证的必要性以及安全应用建议》的文章针对神经影像学中可解释人工智能(XAI)方法的可靠性问题进行了深入研究。研究发现,目前广泛应用的几种XAI方法在神经影像数据上存在系统性缺陷,并提出了一种新的、更可靠的XAI方法应用方案。

文章的核心论点在于,许多被广泛应用于神经影像分析的XAI方法,其设计原则和验证过程主要基于自然图像数据,而神经影像数据具有独特的特征,例如强空间相关性、缺乏标准化对象、特征分布弥散等,导致这些方法在神经影像领域出现系统性失效。这不仅影响了对深度学习模型的可靠解释,也可能导致错误的科学结论和临床决策。

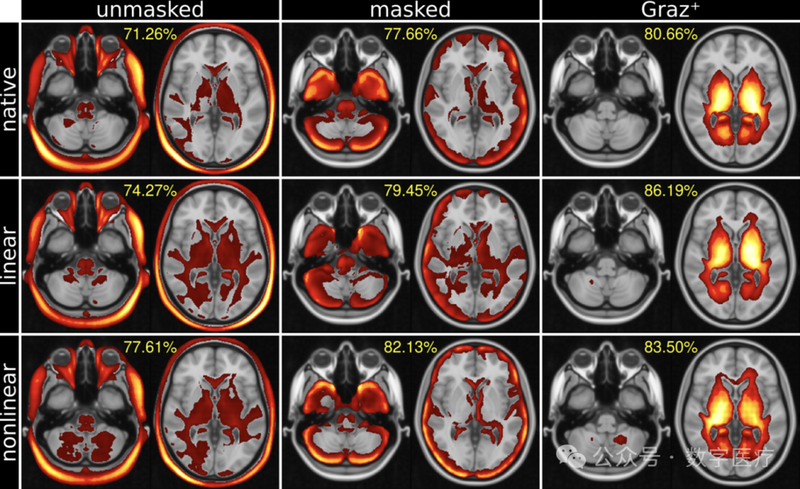

为了验证这一论点,研究人员设计了一个新颖的XAI验证框架,该框架利用约45,000张来自英国生物样本库的结构性脑部MRI扫描数据,通过构建具有已知信号源的预测任务来建立可验证的客观事实。这些预测任务的复杂度逐步递增,从精确的解剖结构特征到临床相关的、个体特异性的分布式模式,涵盖了不同类型的预测目标(例如,区域体积、皮质厚度、脑龄等)。关键的是,该框架没有对输入图像进行人工修改,从而保持了数据的自然统计特性。

该验证框架包含四个阶段:

●局部解剖特征 (校正的影像衍生表型):该阶段使用“校正后的影像衍生表型”作为预测目标,“校正后的影像衍生表型”通过主成分分析去除全局脑效应,确保预测信号仅来自预定义的单一脑区。模型预测的准确性在去除目标区域后显著下降,验证了该方法的有效性。

●可控的分布式模式 (“人工疾病”):该阶段通过组合多个不同脑区的“校正后的影像衍生表型”来创建“人工疾病”,模拟临床中同时存在多个空间分离的异常情况。这建立了分布式效应的明确客观事实,用于测试XAI方法捕捉多区域相关性的能力。

●临床相关的分布式模式 (病灶):该阶段使用“脑白质高信号”病灶负荷作为预测目标,脑白质高信号病灶在个体间的位置和程度差异很大,代表了真实世界中临床相关的分布式模式。个体特异性的病灶分割掩码作为解释的客观事实。

●复杂生物标志物的合理性 (脑龄):该阶段使用脑龄预测作为预测目标,由于缺乏直接的空间客观事实,因此通过与文献中已知的脑龄相关解剖模式进行比较来评估解释的合理性。

研究人员在该框架下对多种XAI方法进行了评估,包括基于梯度的(SmoothGrad, InputxGradient)、基于相关性的(LRP)、基于CAM的(GradCAM)和基于参考的(DeepLift)方法。 结果显示,神经影像学文献中最常用的两种方法——GradCAM和LRP——存在严重的系统性缺陷:GradCAM 持续未能准确定位预测性特征,而LRP 则产生了大量的伪影解释。这些缺陷源于领域不匹配,即为自然图像设计的XAI方法不适用于神经影像数据。

相比之下,一种更简单的基于梯度的方法SmoothGrad,由于其对数据结构的假设较少,在所有测试场景中都表现出较高的准确性。这表明,概念上的简洁性使得SmoothGrad对领域差异更具鲁棒性。

文章进一步通过将相同XAI方法在神经影像数据集和ImageNet自然图像数据集上的性能进行比较,证实了领域不匹配是导致GradCAM和LRP失效的主要原因。 在自然图像数据集上表现良好的方法,在神经影像数据集上表现不佳,反之亦然。

研究人员建议,在神经影像学中应用XAI方法时,应谨慎使用GradCAM和LRP,并推荐使用SmoothGrad作为更可靠的替代方案。虽然SmoothGrad也并非完美无缺,但其在各种复杂度任务中的稳健性能,使其成为目前更可靠的选择。

文章最后强调了特定领域验证的重要性,并呼吁对先前使用未经验证的XAI方法进行重新评估。该研究为神经影像学中XAI方法的安全应用提供了重要的经验指导,并为未来XAI方法的开发和验证建立了坚实的基础。论文也指出了未来研究方向,包括对更多架构、模态和临床数据集进行验证,以及开发更适合神经影像数据特性的XAI方法。