这篇文章介绍了“普瑞姆2”,这是一个基于多模态和临床对话的通用病理学人工智能模型。该模型旨在解决现有病理学基础模型在临床应用中存在的局限性,例如缺乏对全切片图像的整体理解以及缺乏大规模诊断数据训练等问题,从而提升模型在各种下游任务中的泛化能力和实用性。普瑞姆2的核心创新在于它利用临床对话来细化模型的训练,从而学习更具临床意义的表征。

现有方法的不足与普瑞姆2的改进:

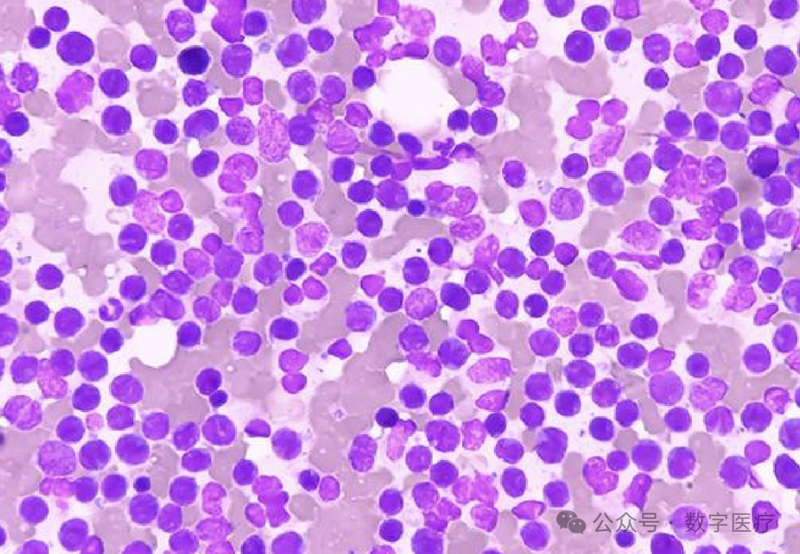

现有的病理学基础模型,例如Virchow2、UNI2和H-optimus-1,主要基于对大量组织切片进行训练,采用自监督学习方法来学习可泛化的表征。这些模型在癌症检测、亚型分类和生物标志物定量等任务上取得了显著进展。然而,这些模型大多停留在切片级别,将它们应用于全切片图像预测仍然需要额外的网络来聚合数万个切片嵌入,这在训练数据有限的情况下容易过拟合。早期的全切片级别模型尝试通过掩码自编码和与临床自由文本报告的对比学习来进行无监督训练,但数据集规模和模型大小仍然有限。

普瑞姆2则通过结合40亿参数的大语言模型和临床对话,对基于临床报告的监督进行了改进。它不仅将全切片图像表征与临床报告进行广泛的对齐,还利用问答来提供细粒度的诊断监督。普瑞姆2是目前为止最大的多模态全切片病理学基础模型,在包含来自不同机构的230万张全切片图像和68.5万份临床报告的大型数据集上进行训练。

普瑞姆2的架构和训练方法:

普瑞姆2采用两阶段训练方法。第一阶段,使用基于感知器的图像编码器和预训练的语言编码器BioGPT,通过对比学习目标来对齐全切片嵌入和文本临床诊断。第二阶段,解冻语言模型,使其能够进行诊断对话,并从隐藏状态中提取更多具有临床意义的表征。模型包含三个主要组件:全切片图像编码器(采用Perceiver架构,但进行了修改以提高效率)、语言编码器(使用BioGPT)和大语言模型解码器(使用Phi-3 Mini)。图像编码器生成两种嵌入:基于对比学习的“基础嵌入”和基于大语言模型隐藏状态的“诊断嵌入”。

为了实现临床相关的对话和报告能力,普瑞姆2使用了GPT-4o生成并整理了各种格式的文本数据,包括报告改写、脱敏病史、样本描述和问答对。这些数据被组合成不同的聊天风格模板,模拟真实的临床对话场景,包括临床报告生成、是/否问答、开放式问答和图像-文本匹配。为了缓解数据集中肯定回答的偏差,本文提出了一种方法来挖掘补充图像以生成额外的问答对。

实验结果和讨论:

普瑞姆2在诊断分类和生物标志物预测任务上取得了优异的性能,超过了之前的全切片级别模型普瑞姆和“提坛“。它还引入了一种零样本是/否分类方法,在无需提示微调或类别枚举的情况下,优于CLIP风格的方法。通过将视觉特征与临床推理对齐,普瑞姆2提高了在数据丰富和样本稀少任务上的泛化能力。

文章通过实验比较了普瑞姆2的“基础嵌入”和“诊断嵌入”在各种下游任务上的性能。结果表明,“诊断嵌入”在癌症检测和亚型分类等任务上表现更好,而“基础嵌入”在生物标志物检测上表现更好。这表明,大语言模型可以进一步提高对诊断图像的理解,而基于对比学习的基础嵌入可能更适合于一些非标准任务。文章还对普瑞姆2的零样本预测能力进行了评估,结果显示,基于对话的问答方法在癌症检测等任务上显著优于基于对比学习的零样本预测方法。

文章还讨论了普瑞姆2在提高训练效率方面的策略,包括序列打包、动态批处理、高效的分组查询注意力和全分片数据并行以及激活检查点等技术。这些技术使得普瑞姆2能够在大规模数据集上进行高效的训练。

结论:

普瑞姆2通过大规模多模态训练、临床对话的引入以及“基础嵌入”和“诊断嵌入”的结合,为构建能够辅助诊断和预后决策的通用病理学AI智能体提供了一种可扩展的途径。该模型在多个病理学任务上取得了显著的成果,展现了其在临床应用中的巨大潜力。 然而,文章也指出,在某些任务(例如生物标志物检测)中,“基础嵌入”可能比“诊断嵌入”更有效,这提示了未来研究方向,即如何更好地结合不同类型的嵌入来提高模型的整体性能。此外,全切片图像的成功也为其他医学影像分析领域提供了宝贵的经验和启示。

如需要《“普瑞姆2”:解锁多模态通用病理AI的临床对话能力》(英文,27页),请在本微信公众号中赞赏(点喜欢或稀罕作者后按本公众号设定打赏)后,发来email地址索取。

Being in good shape is another form of self care, but also a sign of true wealth. 身形康健,乃自爱之姿,亦是真正富足的象征。早上好!